Pourquoi ce retour d’expérience ?

Depuis la démocratisation du « Big Data », les métiers de la Data ont évolués, tant dans l’intitulé que dans le contenu. Il y a encore quelques années, les offres d’emploi concernaient des statisticiens ou des chargés d’études.

En 2016, ces métiers ont été remplacés par de multiples anglicismes comme Data Scientist, Digital Analyst ou Data Engineer. Partout, de nouveaux projets sont lancés, les entreprises sont en constante évolution, il est donc naturel que les attentes des recruteurs ne soient plus les mêmes. Il faut maîtriser de nouveaux outils, développer avec plusieurs langages. Les offres sont devenues plus variées et de fait plus complexes à interpréter.

Ainsi, pour éclaircir ces points et comprendre les attentes de ces nouveaux métiers, nous avons souhaité répondre à la problématique suivante : Quel sont les attentes du marché sur la data aujourd’hui ? Au cours de cet article, nous vous présenterons les différentes étapes du projet puis nous analyserons les données recueillies. Surtout, nous avons intégré de la data visualisation pour que vous puissiez répondre par vous-même à notre problématique.

Quelle démarche mise en oeuvre ?

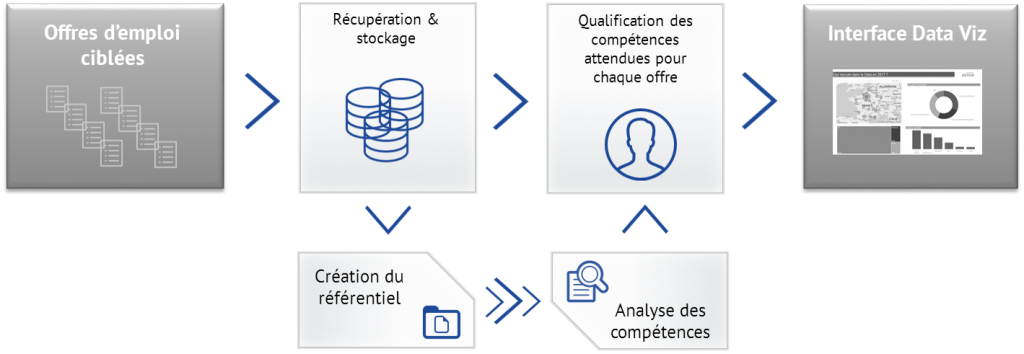

Pour monter ce projet, plusieurs étapes ont été nécessaires pour aboutir à cet article :

La première étape fut de construire une base d’offres, à partir d’une liste de mots-clés que nous avons définie. Nous avons intégré près de 40 termes différents autour de la Data pour collecter les offres d’emplois associées, avec par exemple : Data Scientist, Big Data, Data Analyst, ou encore Chef de projet Business Intelligence.

A partir de cette base riche, nous avons sélectionné uniquement la donnée utile et développé un traitement capable d’identifier automatiquement les champs essentiels pour en récupérer l’information. Nous obtenons donc une base structurée avec plus de 10000 offres avec des variables comme : lieu du poste, intitulé, secteur, type (CDI / CDD) … Ce chantier a été réalisé en Python.

La seconde étape, celle du référentiel, est le cœur de notre projet. Cette étape permet de créer de l’information à partir des données collectées. L’objectif est de faire émerger une catégorisation commune à toutes les offres pour construire une base homogène malgré l’hétérogénéité évidente des offres entre elles. En effet, la structure générale d’une offre semble toujours la même mais le contenu, la façon d’aborder chaque partie (profil candidat, description du poste, compétences, …) est propre à chaque entreprise.

Ainsi, pour rendre exploitable notre base d’offres, nous avons analysé chacune d’entre elles pour harmoniser leur structure.Cette étape a abouti sur la création d’un référentiel hiérarchique basé sur des catégories communes à toutes les offres (secteur d’activité, expériences requises, outils à maitriser,…).

Une fois ce référentiel créé, nous avons automatisé un process qui permet d’intégrer l’offre récupérée dans notre base structurée via le référentiel. A la fin de cette étape, chaque terme utile de chaque offre trouve sa place dans une catégorie de notre référentiel.

Toutes ces étapes nous permettent de disposer d’une base structurée et directement exploitable dans un outil de data visualisation. Celui que nous avons retenu pour vous présenter nos résultats est Microsoft PowerBI.

Retrouvez l’ensemble des résultats & l’animation interactive dans la 2nde partie de cet article.