L’offre de services de Groupe AVISIA est axée sur des briques complémentaires et propres aux projets « data centric ».

Ainsi nous intervenons sur des projets transverses qui se déroulent au sein des équipes opérationnelles de nos clients et partageons leurs problématiques quotidiennes.

Et sur l’année écoulée une grande partie de ces préoccupations a été liée au repositionnement de la « data » au sein de leur stratégie globale.

Décision qui implique la récupération et le traitement de l’ensemble des données disponibles pour améliorer la performance. Mais beaucoup se heurtent à des barrières techniques ou méthodologiques qui finalement peuvent dégrader la productivité.

A ce titre nous travaillons ensemble pour trouver des solutions & apporter nos recommandations sur ce sujet. C’est dans ce cadre que nous avons eu l’opportunité de préconiser et mettre en œuvre une plateforme analytique distribuée sous hadoop.

Contexte de notre intervention :

Notre client avait un enjeu stratégique d’accroître sa capacité à fidéliser et à conserver ses abonnés pour maintenir sa part de marché. Et pour aller plus loin que ses concurrents il souhaitait :

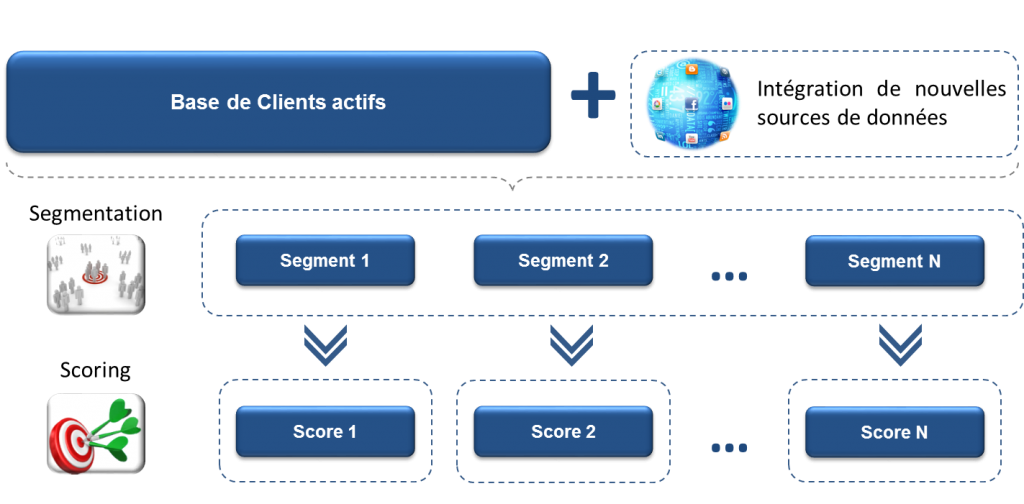

- utiliser l’ensemble des interactions disponibles avec ses clients (magasins, site web, réseaux sociaux, campagnes marketing, … etc.),

- affiner ses offres à des segments de clients très fins (niches) en raison de comportements multiples & atypiques.

Ainsi le besoin de ce client peut se résumer à vouloir traiter plus d’observations, plus d’informations diverses, plus rapidement et créer ainsi un avantage concurrentiel (qui génère de la valeur).

Notre réponse :

Pour y parvenir, nous avons mis en œuvre une double approche : Méthodologique & Technique.

Sur l’aspect « méthode », nos préconisations étaient simples : réduire au maximum l’hétérogénéité des comportements pour mieux les appréhender.

C’est à partir de là que l’aspect « technique » rentre en jeu car nous devions traiter des volumétries importantes avec des granularités et des contenus variés. De plus il fallait bâtir une méthodologie et des algorithmes capables d’être mis à jour rapidement.

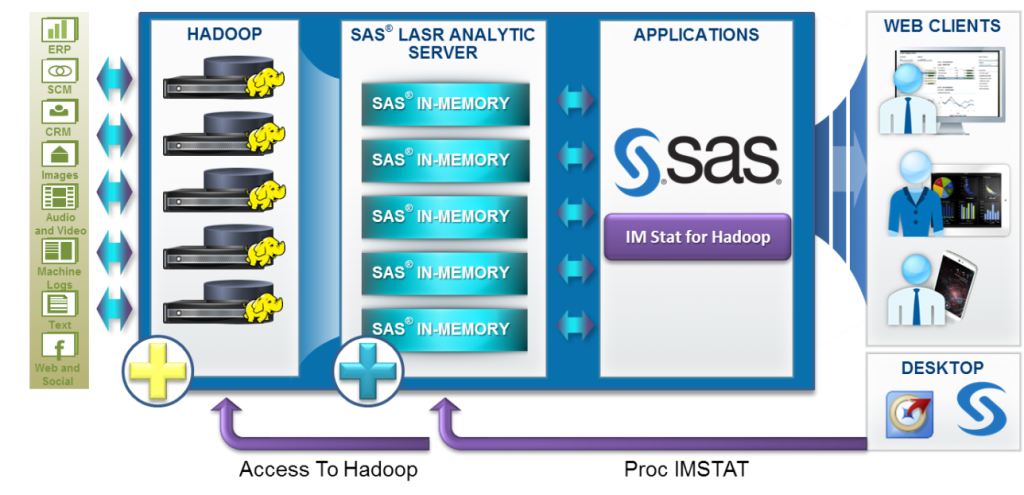

Nous avons donc préconisé et mis en œuvre une plateforme analytique basée sur Hadoop sur laquelle nous avons plugué une solution « In Memory » : SAS In Memory Statistics.

Notre idée était :

- De mettre en place une infrastructure de stockage à moindre coût (Hadoop),

- De développer une approche « in memory » (traitements en quasi temps réel),

- Avec une reprise simple, pour les équipes internes, de leurs programmes / algorithmes existants (sous SAS Base)

Les résultats obtenus :

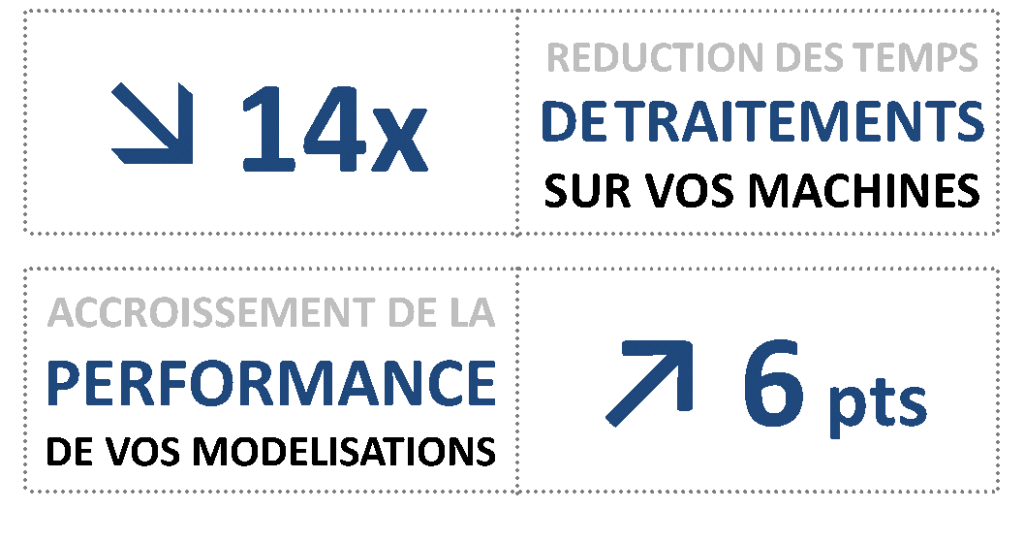

Pour démontrer les apports de nos préconisations, nous avons réalisé la comparaison entre deux algorithmes sur la même problématique : Un algorithme en production chez notre client vs Le MEME algorithme sur notre plateforme.

Et nous avons observé les résultats suivants :

Les principales explications de ces résultats sont :

- Sur la réduction des temps machine : c’est la distribution des traitements sous Hadoop en « in memory » qui a permis de réduire le temps de traitements de la chaîne complète de 11h à 45min

- Sur l’amélioration des performances :c’est la capacité d’intégrer dans notre algorithme plus de 200 variables avec un apprentissage sur l’ensemble des données clients qui a permis d’améliorer la performance (mesurée via le critère d’AUC sur une régression logistique).

En conclusion, suite à ce retour d’expérience, il nous semble intéressant et important de montrer qu’aujourd’hui ce type d’approche, très concrète & pragmatique, peut-être pour beaucoup d’entreprises un premier exemple sur l’apport et l’intérêt des nouvelles technologies liées au Big Data.

C’est en tout cas avec cette vision et avec une constante recherche du ROI que nous conduisons et mettons en œuvre au quotidien des projets « data centric » chez nos clients.