Il est courant de faire le parallèle entre l’essor du Machine Learning et celui du Big Data … or si on se réfère aux tendances mesurées par Google, le lien ne semble pas si évident :

En 2015, en analysant les termes des recherches associées, l’intérêt pour le Machine Learning est principalement lié à la Formation & MOOC

Ceci montre une désynchronisation qui peut être bloquante vis-à-vis des attentes des entreprises qui souhaitent utiliser le « Big Data » pour mettre en œuvre des nouveaux « use cases ».

C’est pour cela qu’au sein du Groupe AVISIA notre idée n’est pas de proposer des externalisations mais plutôt d’accompagner au mieux les différentes directions à faire face à ces nouveaux challenges pour leur permettre d’internaliser ces chantiers et d’embarquer les équipes internes dans la réalisation.

Au cours de l’un de nos précédents articles sur le « Machine Learning », nous avons décomposé notre vision du sujet et détaillé l’approche que nous préconisons : Lire l’Article

Le but de ce nouvel article est aujourd’hui de vous donner des ordres de grandeur et des notions du ROI que vous pouvez espérer sur ce type de projet.

Pour y parvenir notre évaluation se porte sur les 3 axes de notre approche :

- La partie « Algorithme » via la mesure de l’amélioration des performances de prédiction,

- La partie « Automatisation » via la mesure de la reproductibilité de l’approche,

- La partie « Exécution » via la mesure des gains en temps de traitements.

Au cours de l’année 2015 nous avons pu évaluer les gains sur chacune de ces parties, sur différents projets au sein de multiples secteurs, que nous vous proposons de partager aujourd’hui.

Pour chaque item, nous comparons une vision dîte « actuelle » qui répresente un mode de fonctionnement analytique classique, avec une approche « Machine Learning » qui consiste mettre en oeuvre nos préconisations de démarche.

Partie « Algorithme »

Pour mesurer les gains de l’optimisation des performances de prédiction existantes, nous nous sommes appuyés sur le taux d’identification de clients bien classés parmi 5% de la population.

Critère défini par le niveau moyen en terme de contacts sortants généralement réalisables.

(**) Base 100 du volume de clients bien classés.

En optimisant la méthodologie, nous observons en moyenne une meilleure performance (+20%) que nous avons réussi à atteindre ce niveau de performance avec différentes combinaisons d’algorithmes.

Le choix final doit alors s’effectuer à l’aide des critères d’automatisation & d’exécution.

Partie « Automatisation »

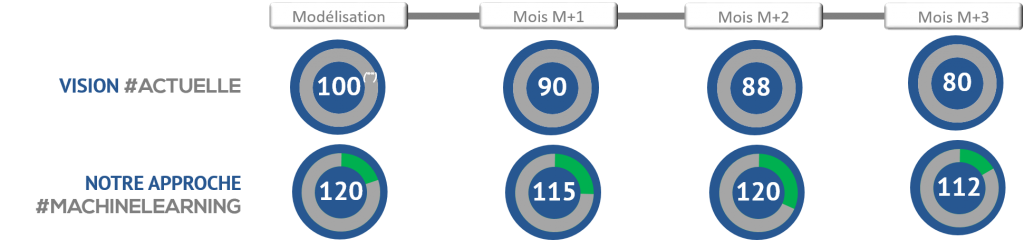

Pour mesurer les gains de la reproductibilité de la méthodologie, nous nous sommes également appuyés sur le taux d’identification de clients bien classés parmi 5% de la population.

Et nous avons comparé le fait de bâtir un modèle sur une période puis de le ré appliquer chaque mois suivant contre le fait de re bâtir à chaque période un nouveau modèle.

(**) Base 100 du volume de clients bien classés.

Sur l’approche actuelle, la performance se dégrade au fil des mois avec la ré application du même modèle.

En optimisant la méthodologie et en recalculant à chaque période le meilleur modèle, la performance reste stable dans le temps ce qui assure un pouvoir de captation significativement meilleur en cumulé (+30% sur 1 trimestre).

Partie « Exécution »

Pour mesurer les gains de l’optimisation en temps de traitements, nous nous sommes appuyés sur le temps de calcul nécessaire pour modéliser & appliquer un algorithme.

La comparaison des temps de traitements est faîte entre une architecture distribuée (3 machines / 36 Cores / 384 Go de RAM) et une architecture client – serveur (1 machine / 12 Cores / 128 Go de RAM).

(*) Temps d’éxeciution en Base 100.

L’utilisation d’une architecture distribuée permet donc de reduire de façon très significative les temps de traitements, ce qui ouvre la possibilité d’utiliser des algorithmes plus complexes sur des jeux de données plus importants.

L’intérêt de coupler l’approche « algorithme » avec la vision « exécution » permet de garantir la mise en œuvre opérationnelle de ce type de démarche. En effet aujourd’hui trop de démarches orientées « algorithme » ne franchissent pas le pas de la mise en œuvre faute de capacité d’industrialisation.

Conclusions

Au final, il est intéressant de retenir que ce type d’approche génère rapidement des gains en terme de performance que ce soit des modèles ou des temps de traitement.

Ces métriques moyennes, que nous avons pu observer sur différents projets au sein de multiples secteurs, peuvent vous permettre de vous projeter avec vos propres inputs. Ainsi il devient plus simple d’évaluer la rentabilité que vous pouvez espérer sur vos projets et donc mettre en place des moyens en adéquation.