Les réseaux sociaux prédisent Miss France

Chaque année, le concours Miss France passionne des millions de Français. Mais si le soir de l’élection ce sont le public et le jury qui tranchent, les réseaux sociaux, eux, livrent souvent leurs pronostics bien avant.

Avec plus de 60 % de la population mondiale présente sur les plateformes sociales en 2024, ces dernières sont devenues de véritables baromètres d’opinion. Entre likes, partages et commentaires, elles regorgent de données précieuses pour anticiper les tendances… et peut-être même deviner le nom de la future reine de beauté.

Chez AVISIA, chaque année depuis 2017 nous relevons un défi : prédire les résultats de l’élection Miss France grâce à l’Intelligence Artificielle. À travers ce projet interne original, dont vous trouverez les détails dans cet article, les données issues des réseaux sociaux Instagram, X et Tiktok sont exploitées pour capter l’opinion du public, mesurer la notoriété des candidates, et analyser les signaux révélateurs des préférences du public. Cette popularité est complétée d’une analyse de sentiment, via de la GenAI, qui a pour but d’évaluer une tonalité des conversations autour de chaque Miss.

Comment collecter les données issues des réseaux sociaux ?

-

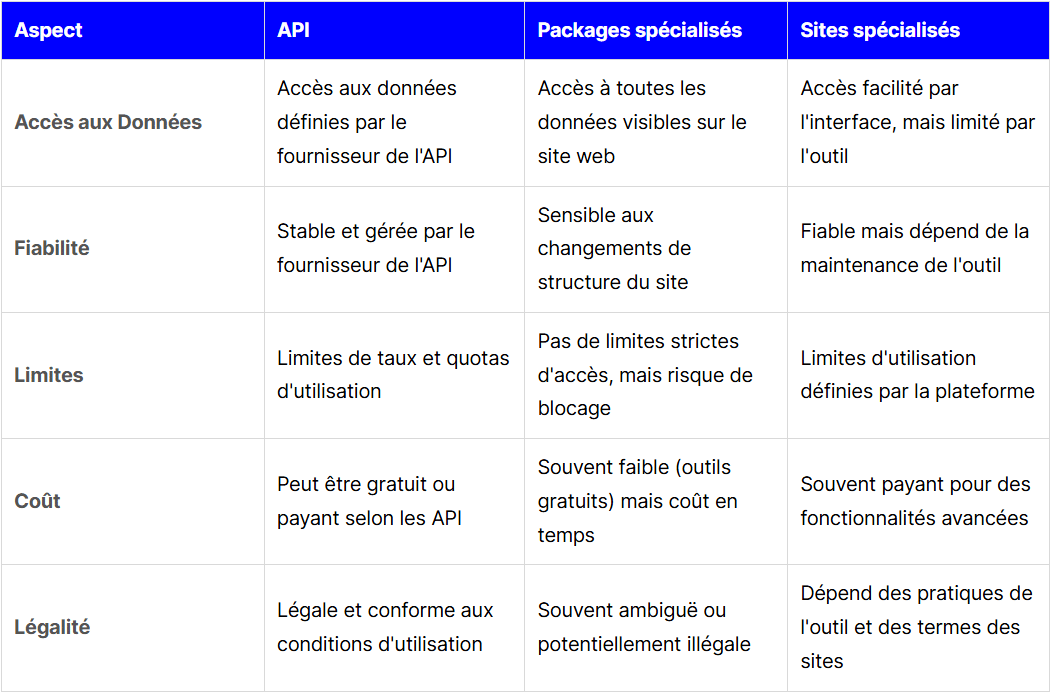

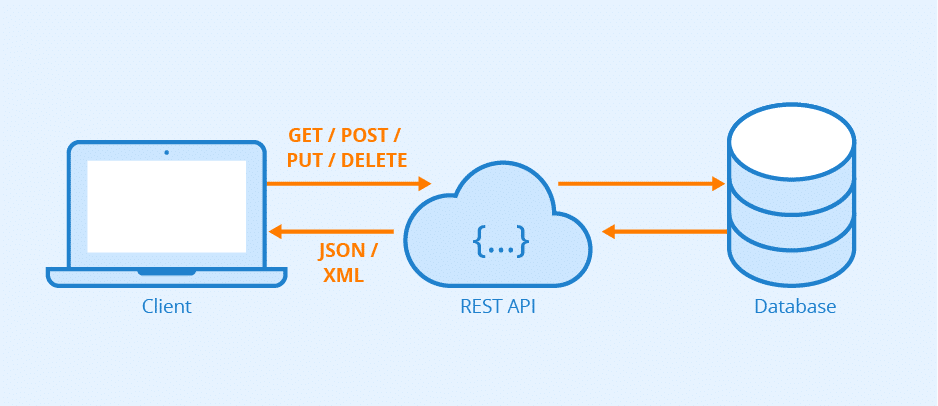

Les API sont des interfaces fournies par des plateformes ou des services web et permettent aux développeurs d’accéder aux données de manière structurée et sécurisée.

-

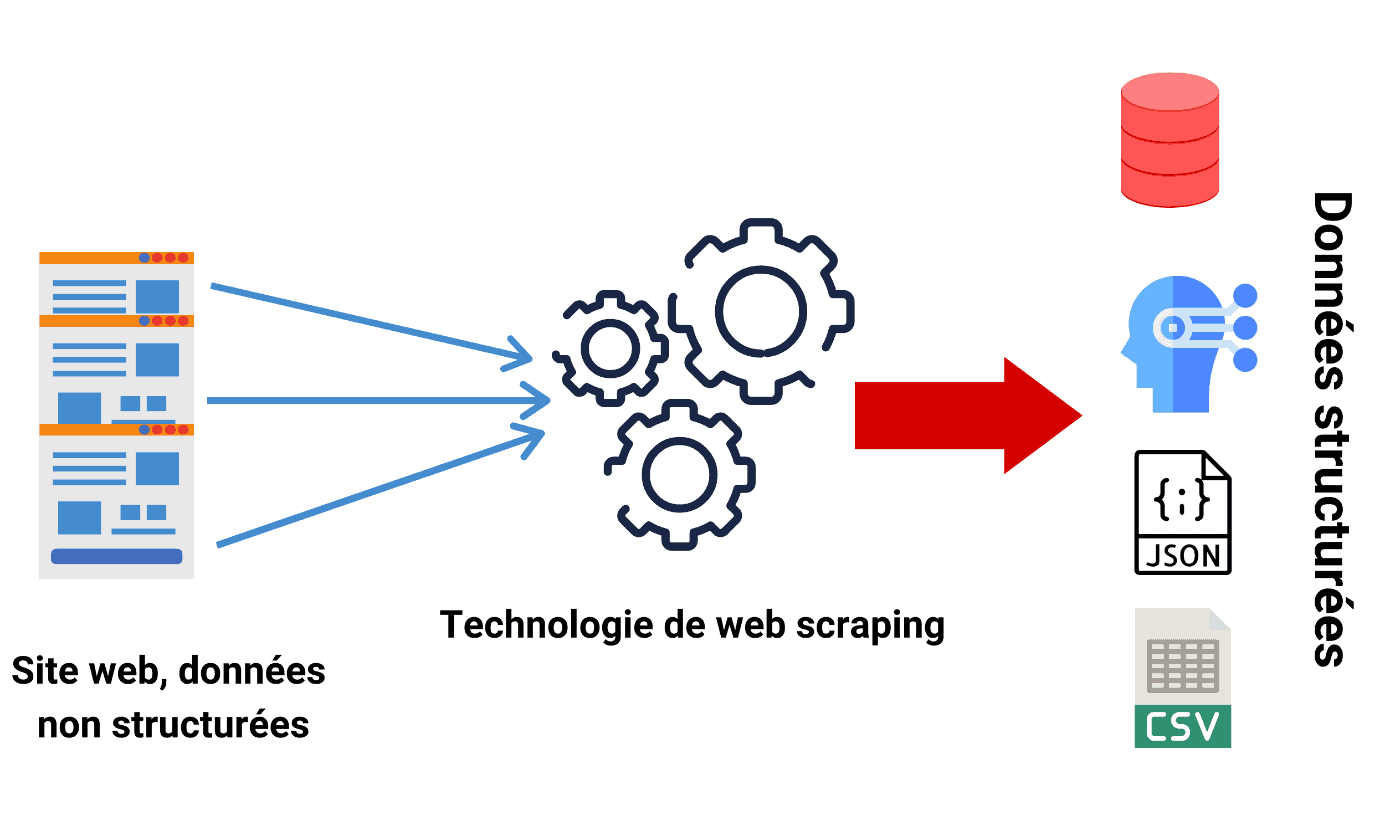

L’utilisation de packages spécialement conçus pour l’extraction de contenu et d’informations issues de sites web.

-

Des sites spécialisés, qui proposent une solution clé en main, avec des services qui automatisent le processus de collecte de données, souvent via une interface utilisateur simple et sans besoin de codage.

Utilisation des API

API Graph – Meta : Instagram, Facebook, WhatsApp, etc

-

Hashtag IG, qui collecte des données liées à un hashtag : nombre de commentaires, de likes, etc.

-

Business Discovery, qui collecte des données liées à un profil : nombre de followers, de posts, de likes, de commentaires, etc.

API X v2 – X (anciennement Twitter)

Depuis l’acquisition de X par Elon Musk en octobre 2022, les politiques d’utilisation de l’API X ont beaucoup évolué et sont devenues plus restrictives. Pour obtenir l’accès à l’API, il faut détenir un compte Développeur qui permettra d’accéder à l’API X v2.Cependant, si l’on souhaite scraper, un compte payant sera nécessaire. En effet, la version gratuite est très limitée et permet seulement de poster jusqu’à 1 500 posts par mois. Pour pouvoir lire des tweets, une version payante est obligatoire avec un coût pouvant aller jusqu’à plus de 5 000$ par mois.

API TikTok

-

Display API, qui permet l’affichage de vidéos TikTok

-

Content Posting API pour la publication de contenu sur le réseau social

-

Research API, qui permet d’accéder à des données analytiques et des informations détaillées sur les tendances, les performances des vidéos, et les comportements des utilisateurs.

Combinaison des API avec des approches ELTQu'est-ce que l'ELT Data ? L'ELT (pour Extract, Load, Transform, ou Extraction, Chargement, Transformation en français) est une méthodologie moderne d'intégration des données qui a émergé avec l'essor du Cloud Computing et des solutions de Big Data (Data Lakes, Data Warehouses Cloud-native). C... More (Extract, Load, Transform) à travers des plateformes spécialisées

Utilisation de packages spécialisés

Scraping avec Selenium et BeautifulSoup

Scraping Instagram avec Instaloader

Exemples de packages spécialisés dans le scapring

-

Minet est une librairie Python développée par le Médialab de Science Po. Ce package a été conçu dans le but de collecter et extraire une grande variété de sources web, y compris les données des réseaux sociaux tel que Facebook, X, Instagram, etc.

-

Gazouilloire, également développé par le Médialab de Science Po, permet de collecter des tweets.

- Linkedin_scraperpermet de scraper le réseau social LinkedIn.

Utilisation de sites spécialisés

Apify

Octoparse

Comment analyser les réseaux sociaux et faire ressortir les tendances ?

Analyser les conversations en ligne autour des candidates du concours Miss France est un exercice aussi passionnant que complexe

Initialement centré sur X (anciennement Twitter), notre modèle a su évoluer pour s’adapter aux nouveaux usages des réseaux sociaux. L’intégration d’Instagram, puis de TikTok a permis de mieux refléter les dynamiques d’interaction et de popularité auprès d’un public plus jeune et diversifié.

Ces plateformes se distinguent par un mode d’expression spontanée et créative : abréviations, emojis, utilisation de nouvelles expressions, multilinguisme… Des caractéristiques qui rendent l’analyse des sentiments et des intentions particulièrement complexe pour des modèles traditionnels, souvent basés sur des règles fixes ou des dictionnaires.

Mesurer la notoriété des Miss grâce à l’IA Générative

L’introduction de l’IA générativeQu'est-ce que l'IA générative ? L'IA générative (intelligence artificielle générative) est une sous-branche de l'intelligence artificielle qui se concentre sur la création de nouveaux contenus, que ce soit des textes, des images, des vidéos ou d'autres formats, à partir des données d'entra... More, et plus spécifiquement des LLM (Large Language Models), a profondément transformé notre capacité à analyser les commentaires issus des réseaux sociaux. Contrairement aux modèles traditionnels, les LLM sont capables de saisir les subtilités du langage naturel, même lorsqu’il est informel, créatif ou hybride.

En intégrant directement les commentaires dans ces modèles, nous pouvons interpréter avec bien plus de justesse des nuances complexes : ironie, double sens, phrases multilingues, ou encore combinaisons de texte et d’emojis. Là où une analyse classique aurait échoué, un LLM comprend par exemple que le commentaire «OMG, c’est le ![]() ce concours» reflète une opinion positive.

ce concours» reflète une opinion positive.

Cette capacité d’analyse fine permet de mieux qualifier les sentiments exprimés et, in fine, d’améliorer la fiabilité de nos prédictions. En enrichissant notre modèle avec des outils de GenAI, nous adaptons notre approche à l’évolution du langage en ligne… et restons au plus près de la voix du public.

Conclusion

Dans un monde où les réseaux sociaux façonnent de plus en plus l’opinion publique, leur analyse est devenu un enjeu clé. Notre projet Miss France démontre comment la data scienceQu'est-ce que la Data Science ? La Data Science, ou science des données, est une discipline interdisciplinaire qui utilise des méthodes scientifiques, des processus, des algorithmes et des systèmes pour extraire des connaissances et des insights à partir de données, qu'elles soient structurées... More, enrichie par l’IA générative, permet non seulement d’analyser des volumes massifs de données sociales, mais aussi d’en extraire du sens.

Ce cas d’usage illustre notre capacité à combiner nouvelles technologies, expertise métier et compréhension des usages digitaux pour anticiper les tendances et prédire les préférences du public. Plus qu’un exercice technique, il s’agit d’un véritable laboratoire d’innovation, où chaque édition Miss France nous pousse à adapter nos outils et affiner nos modèles.

Ophélie TOURLAN & Solène VENEZIA

Articles en lien

Data contact

Avec notre expertise, faites parler vos données